Emote Portrait Alive简介

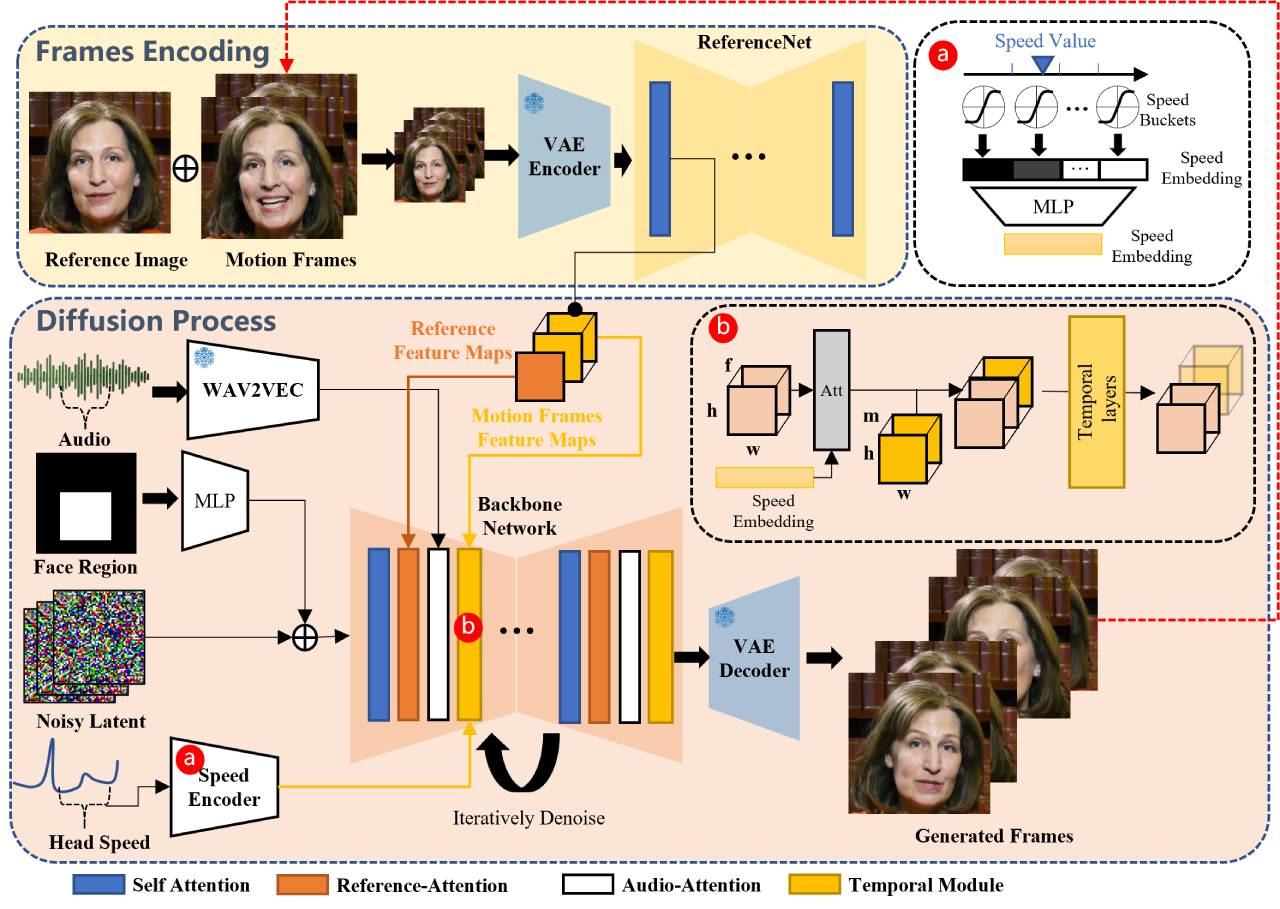

Emote Portrait Alive是阿里巴巴发布的EMO,一种音频驱动的AI肖像视频生成框架。输入单个参考图像和声音音频,例如说话和唱歌,Emote Portrait Alive就可以生成具有表情丰富的面部表情和各种头部姿势的声音肖像视频,让照片中的人物根据音频内容自然地张嘴说话或唱歌,面部表情和头部姿态非常逼真。同时,我们可以根据输入视频的长度生成任意持续时间的视频。

Emote Portrait Alive功能和特点:

- 音频驱动的视频生成:EMO能够根据输入的音频(如说话或唱歌)直接生成视频,无需依赖于预先录制的视频片段或3D面部模型。

- 高表现力和逼真度:生成的视频具有高度的表现力,能够捕捉并再现人类面部表情的细微差别,包括微妙的微表情,以及与音频节奏相匹配的头部运动。

- 无缝帧过渡:确保视频帧之间的过渡自然流畅,避免了面部扭曲或帧间抖动的问题,从而提高了视频的整体质量。

- 身份保持:通过FrameEncoding模块,EMO能够在视频生成过程中保持角色身份的一致性,确保角色的外观与输入的参考图像保持一致。

- 稳定的控制机制:采用了速度控制器和面部区域控制器等稳定控制机制,以增强视频生成过程中的稳定性,避免视频崩溃等问题。

- 灵活的视频时长:可以根据输入音频的长度生成任意时长的视频,为用户提供了灵活的创作空间。

- 跨语言和跨风格:训练数据集涵盖了多种语言和风格,包括中文和英文,以及现实主义、动漫和3D风格,使得EMO能够适应不同的文化和艺术风格。

Emote Portrait Alive应用场景:

- 唱歌视频生成:输入一张人物肖像照片和唱歌音频,EMO可以生成与音频同步且富有表现力的唱歌视频。

- 说话视频生成:不仅限于唱歌,还可以处理说话音频,生成与语音同步的说话视频。

- 多语言支持:支持多种语言的音频输入,能够生成不同语言下的人物肖像视频。

- 跨风格应用:可以将不同风格(如动漫、3D模型等)的肖像图像与音频结合,生成具有特定风格的视频内容。

Emote Portrait Alive不仅限于处理唱歌的音频输入,还可以容纳各种语言的口语音频。此外,Emote Portrait Alive还能够将过去的老照片、绘画以及 3D 模型和AI生成的内容制作成视频,为它们注入逼真的动作和真实感。

数据统计

数据评估

关于EmotePortraitAlive特别声明

本站土豆丝提供的EmotePortraitAlive都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由土豆丝实际控制,在2025年8月15日 上午12:41收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,土豆丝不承担任何责任。

相关导航

M2UGen,一款融合了音乐理解和多模态音乐生成任务,旨在助力用户进行音乐艺术创作的引领潮流的框架。

Hyprnote

Hyprnote,一个开源的会议笔记AI工具,适合经常参加会议的人使用。Hyprnote能实时把会议内容录下来并转成文字,还能整理出会议要点。

TryOnDiffusion

TryOnDiffusion,TryOnDiffusion就谷歌推出的一项新虚拟试穿功能,能够实现高度逼真的虚拟试穿,用户能够直观地看到不同体型的人穿着不同尺寸的衣服效果如何。

Platon.AI-柏拉图智能

Platon.AI - 柏拉图智能,Platon.AI柏拉图智能不仅仅是 AI 爬虫,也是 AI agents 的基础设施。 AI agents 要使用工具,就必须高速阅读理解在线网页,理解网页上的每一个元素——这就是 platon.AI 的技术。

Davia

Davia,一款开源网页生成工具,目标是提供类似大厂那种“所见即所得”的网页生成功能。它基于 FastAPI 开发,安装起来非常简单,只需要运行 pip install davia 就能搞定。

Zion

Zion,一个全栈的零代码开发工具,快速搭建个性化应用!能够帮助用户从应用开发、部署上线到增长运维的全过程,且全程零代码开发可视化。

TrickleAI

Trickle AI,一款基于AI的零代码开发工具,用户可以通过自然语言描述需求,快速生成网页、表单和应用,支持一键部署访问,Trickle适合小商家、创业者、设计师和普通开发者。

FlashVideo

FlashVideo,字节跳动和香港大学联合推出的一种高效的高分辨率视频生成框架,适用于文本到视频的生成。

暂无评论...