JoyGen简介

JoyGen 是由京东科技与香港大学合作开发的音频驱动3D说话人脸视频生成框架,一种新颖的两阶段框架,这个技术在于通过音频输入来驱动3D深度感知模型,提供精确的唇部与音频同步,以精确模拟说话者的唇部动作和面部表情,让生成的视频更逼真,主要应用于视频编辑和虚拟交互领域。

JoyGen使用了一个包含130小时高质量视频的中文说话人脸数据集进行训练。这个数据集与开放的HDTF(高分辨率深度图数据集)结合,支持中文和英文输入。

另外,JoyGen也考虑了音频的情绪特征,能够在生成的动画中自然地表现出人物的情感变化,例如微笑或皱眉等,非常的强。

JoyGen核心功能:

- 多语言支持:JoyGen能够处理中文和英文等多种语言的音频输入。

- 高质量视觉效果:通过细致的面部表情和唇部细节处理,生成的视频极其逼真。

- 精确唇部同步:通过音频特征分析和面部深度图技术,使视频中人物的唇部动作与音频内容完美匹配。

- 视频编辑优化:不仅生成新视频,还能对现有视频进行唇部运动的编辑,不需要从头开始又制作整个视频序列。

- 高效技术架构:采用单步UNet架构,可以让视频编辑流程更简单了。

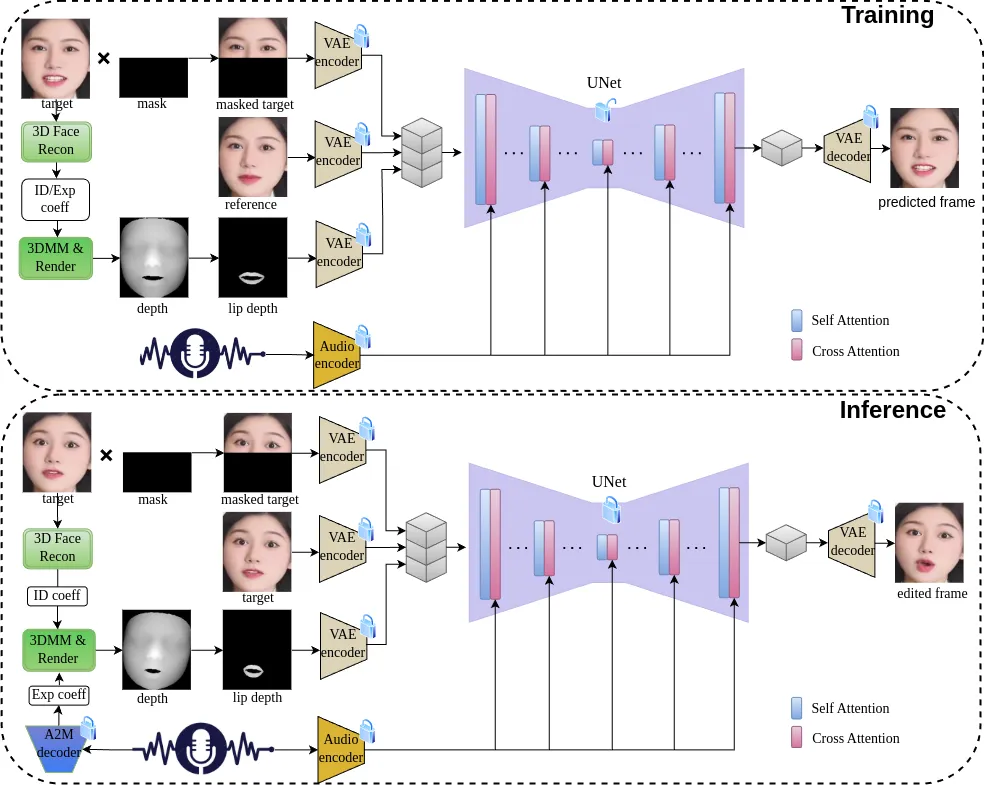

技术原理:

1. 音频驱动的唇部动作生成:

- 利用3D重建模型从面部图像提取身份特征,定义人物的独特面部结构。

- 通过音频到运动模型,将音频信号转换为控制唇部运动的表情系数。

- 结合身份和表情系数,使用可微渲染技术生成面部深度图,为后续视频合成准备。

2. 视觉外观合成:

- 采用单步UNet网络整合音频特征与深度图,直接生成包含精确唇部运动的视频帧。

- 引入跨注意力机制,确保唇部运动与音频信号高度一致,增强同步性。

- 通过优化过程(如L1损失函数)确保视频质量,兼顾像素级和潜在空间的准确性。

如何使用JoyGen:

- 环境搭建:用户需创建一个特定的conda环境,并安装必要的依赖包,包括Nvdiffrast等特定库。

- 预训练模型下载:获取JoyGen的预训练模型,包括3D模型、音频到运动模型等,这些资源通常在项目GitHub页面上提供。

- 运行推理:通过执行特定的脚本和参数,用户可以将音频文件转换为带有逼真唇部同步的3D说话人脸视频。

JoyGen应用:

- 虚拟会议:增强虚拟会议中的面部表达。

- 影视制作:制作电影和电视中的特效。

- 教育培训:用于制作生动的教育视频。

- ai助手:增加Ai助手在人与机器互动中的拟人程度。

JoyGen将复杂的人脸视频生成大大简化了,它在数字人内容创作、虚拟会议、娱乐等地方有非常大的作用。

GitHub:https://github.com/JOY-MM/JoyGen

数据统计

数据评估

关于JoyGen特别声明

本站土豆丝提供的JoyGen都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由土豆丝实际控制,在2025年8月15日 上午12:18收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,土豆丝不承担任何责任。

相关导航

Branchbob.Ai,Branchbob 是一个由 AI 驱动的在线商城生成器,可让您在几分钟内创建一个功能齐全、搜索引擎优化的商城。

CustomNet

CustomNet,CustomNet旨在更好地将指定物品的图片融合到新生成的图片中,并确保原物品的样式和纹理细节得以还原。这项技术给SD商品图融合带来了一线生机。

Ezindie

Ezindie,独立开发者变现周刊,让小产品的变现更简单,一个专注于分享独立开发者如何创造和变现其产品的周更内容,提供关于独立开发产品如何实现商业成功的案例和故事。

Perplexica

Perplexica,一个提供高质量搜索体验的开源AI驱动搜索引擎,Perplexica通过理解用户问题并利用机器学习算法来提供精准的搜索结果。

1000UserGuide

1000UserGuide,一个为独立开发者提供一个丰富的获客资源渠道网站,1000UserGuide精心整理了300多个国内外渠道,专门适合独立开发者和创业者推广产品的渠道。

IndieResources.dev

IndieResources.dev,一个专为独立开发者提供的免费资源导航站。IndieResources汇集了超过1000种免费资源,涵盖教程、社交媒体工具、支付解决方案、域名注册、部署服务、设计工具、代码编程资源等。

10WEB人工智能建站

10WEB人工智能建站,10Web是一个基于Elementor的人工智能驱动的网站建设工具,提供类似于WordPress的块状编辑器,并增加了安全功能、后端优化和AI工具。

NeuraPress

NeuraPress,一款专注于微信公众号排版的Markdown编辑器,支持移动端,搭配DeepSeek和微信公众号助手,利用碎片化时间,通过手机就能编辑并发布带有排版效果的公众号文章。

暂无评论...