Tarsier简介

Tarsier是字节跳动推出的一系列大规模视觉语言模型(LVLM),专注于视频理解任务,包括视频描述、问答、定位和幻觉测试等功能。

Tarsier主要功能

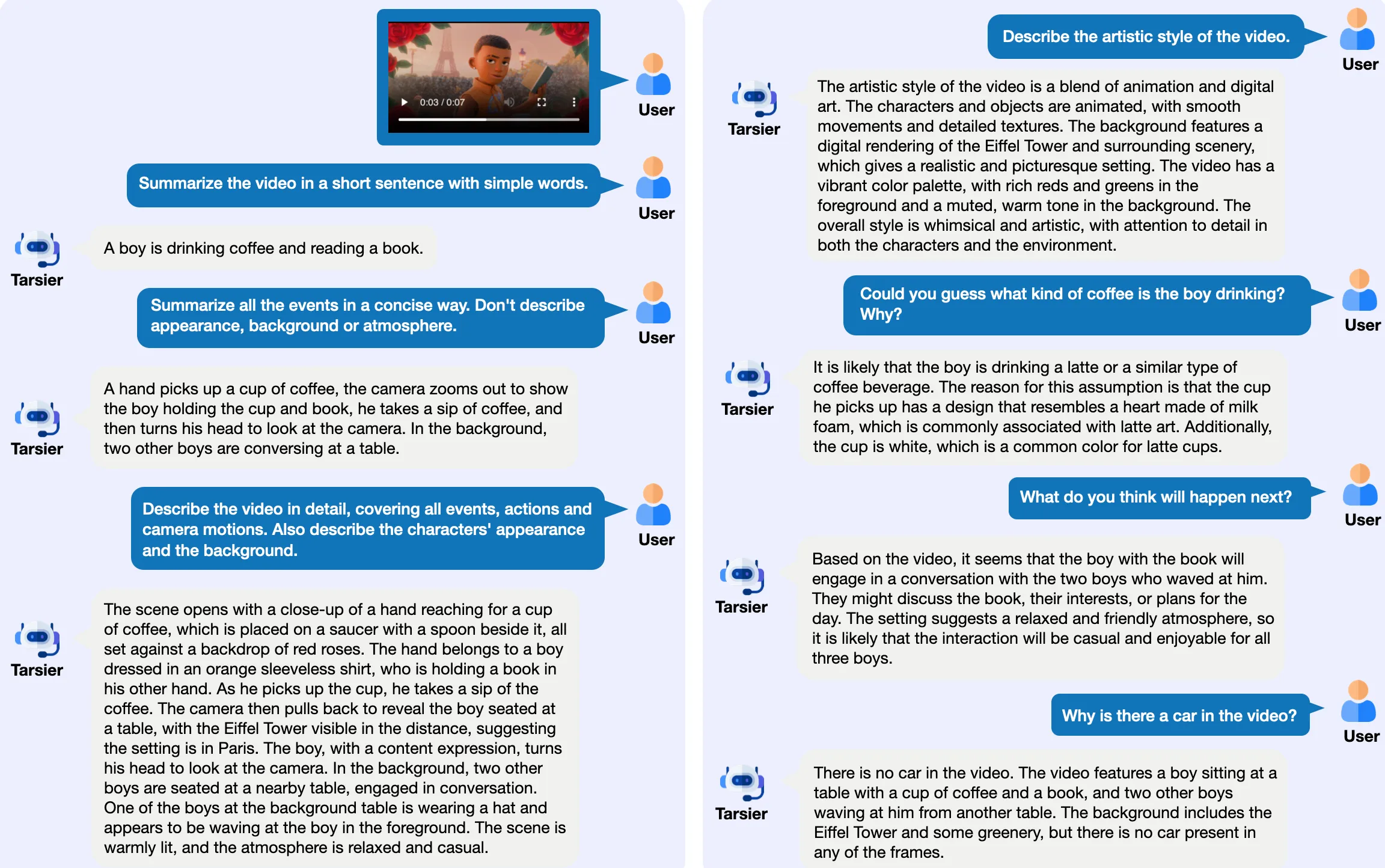

- 视频描述生成:Tarsier能生成高质量的视频描述,覆盖视频中的各种细节,包括动作、场景和情节,帮助用户更好地理解视频内容。

- 问答能力:Tarsier模型支持视频问答功能,用户可以基于视频内容提出问题,模型将提供相关的答案。

- 定位功能:检测并定位视频中特定事件发生的时间,支持多视频段的定位,可以在视频中识别和标记特定对象或场景。

- 幻觉测试:通过优化训练策略,Tarsier2显著减少了模型生成虚假信息的可能性。

- 多语言支持:支持多种语言的视频描述生成。

Tarsier应用场景:

- 内容创作:Tarsier可以帮助内容创作者生成视频描述,提升视频的可访问性和搜索引擎优化(SEO)效果。

- 教育领域:在教育视频中,Tarsier可以提供详细的内容描述,帮助学生更好地理解学习材料。

- 社交媒体:社交平台可以利用Tarsier生成视频内容的自动描述,增强用户体验。

- 视频监控:在安全监控领域,Tarsier可以分析视频流并生成实时描述,帮助安全人员快速识别潜在威胁。

- 机器人:为指定任务生成详细的步骤指令。

- 智能驾驶:帮助车辆识别道路情况,并辅助进行决策。

Tarsier模型的最新版本Tarsier2在多个方面进行了显著的改进,特别是在数据量和多样性方面。预训练数据从1100万扩展到4000万视频文本对,增强了模型的学习能力。此外,Tarsier2在监督微调阶段引入了细粒度时间对齐,进一步提高了视频描述的准确性和细节捕捉能力。通过直接偏好优化(DPO)训练,Tarsier2能够生成更符合人类偏好的视频描述,减少生成幻觉的可能性。

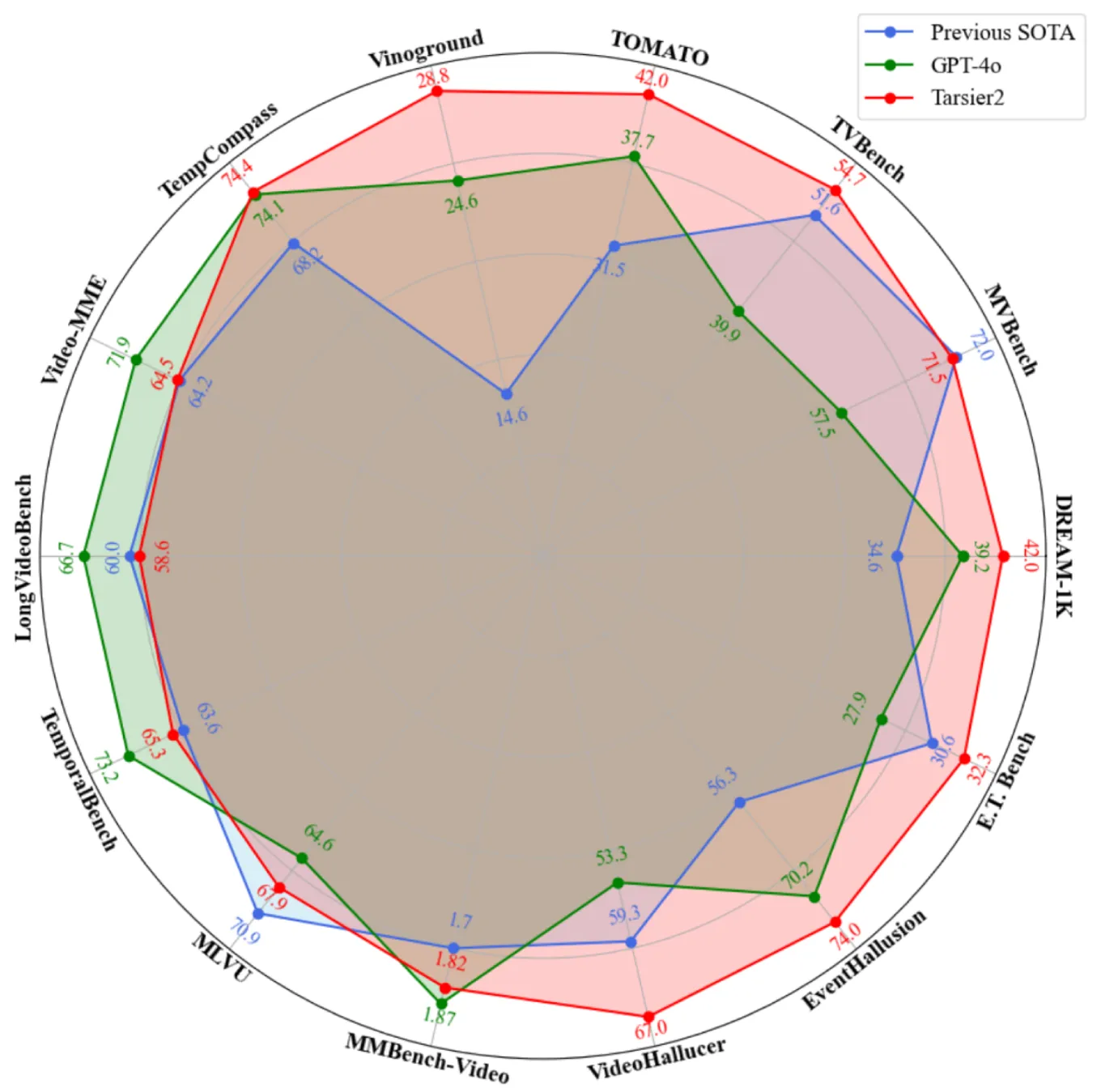

在性能评估方面,Tarsier2在DREAM-1K基准测试中表现出色,其F1分数比GPT-4o高出2.8%,比Gemini-1.5-Pro高出5.8%。在15个公共基准测试中,Tarsier2取得了新的最佳结果,涵盖视频问答、视频定位、幻觉测试和问答等功能,展示了其作为强大通用视觉语言模型的多功能性。

除了视频描述之外,它还在问答、grounding和embodied intelligence等任务中展现出强大的性能。

论文:https://arxiv.org/abs/2501.07888

Code: https://github.com/bytedance/tarsier

Dataset: https://huggingface.co/datasets/omni-research/DREAM-1K

Demo: https://huggingface.co/spaces/omni-research/Tarsier2-7b

数据统计

数据评估

本站土豆丝提供的Tarsier都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由土豆丝实际控制,在2025年8月15日 上午12:20收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,土豆丝不承担任何责任。

相关导航

Stunning.so

Colors

SoraWebui

AgentTARS

CustomNet

Chibi.Ai

PiliPala